Technology

Featuring Technology

Company

SoftNeuro®

「SoftNeuro®」は、世界最速級のディープラーニング推論エンジンです。主要なディープラーニング・フレームワークを用いて行われた学習結果を活用して、エッジデバイスなどの様々な環境上で高速な処理を実行します。

「SoftNeuro®」は、世界最速級(※1)のディープラーニング推論エンジンです。主要なディープラーニング・フレームワークを用いて行われた学習結果を活用して、エッジデバイスなどの様々な環境上で高速な処理を実行します。(図1)

また、汎用的な推論エンジンであるため、画像認識だけでなく、音声認識やテキスト解析等にも利用可能です。

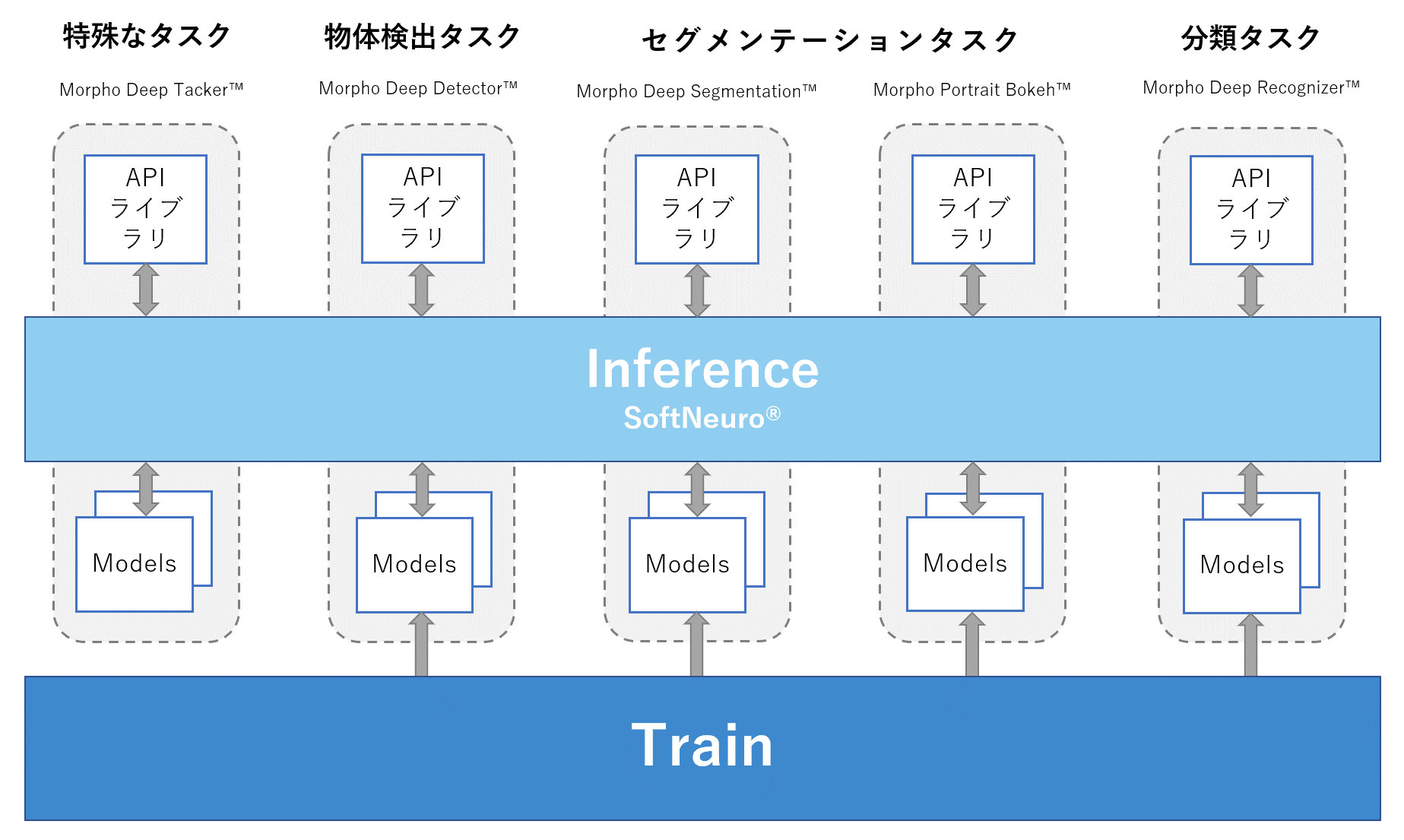

単体でライセンス提供することもできますが、モルフォの既存の画像向け認識エンジン「Morpho Deep Recognizer™」等に組み込むことで、それら既存エンジンの更なる高速化が実現可能です。

1.世界最速級(当社調べ)(※1)

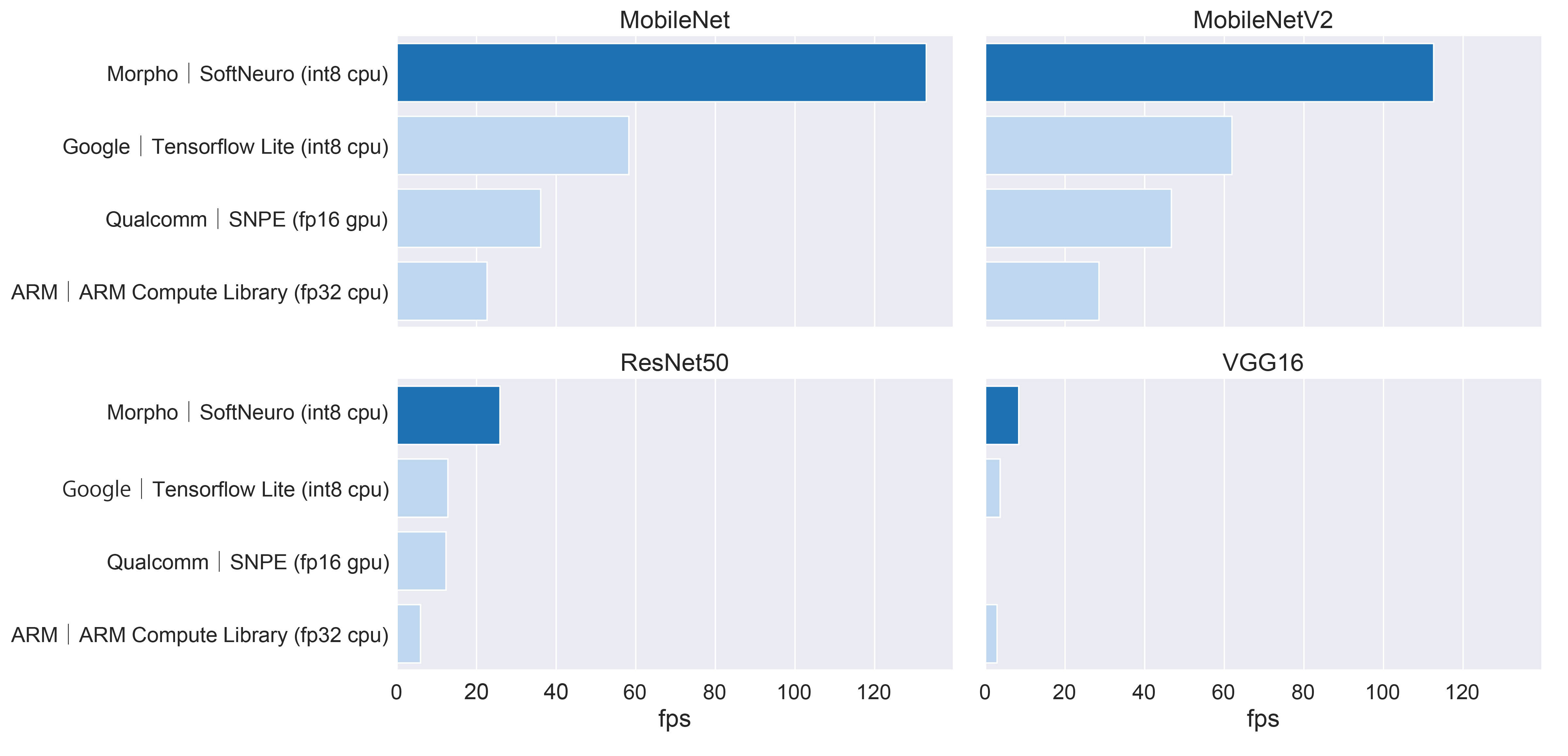

「SoftNeuro®」は、後述の特徴も備えながら、CPUのみの処理において世界最速級の処理速度で推論処理を実行します。この高速性は、ニューラルネットワークやメモリ使用方法などを各プラットフォーム向けに最適化することで実現しています。

2.マルチフレームワーク対応

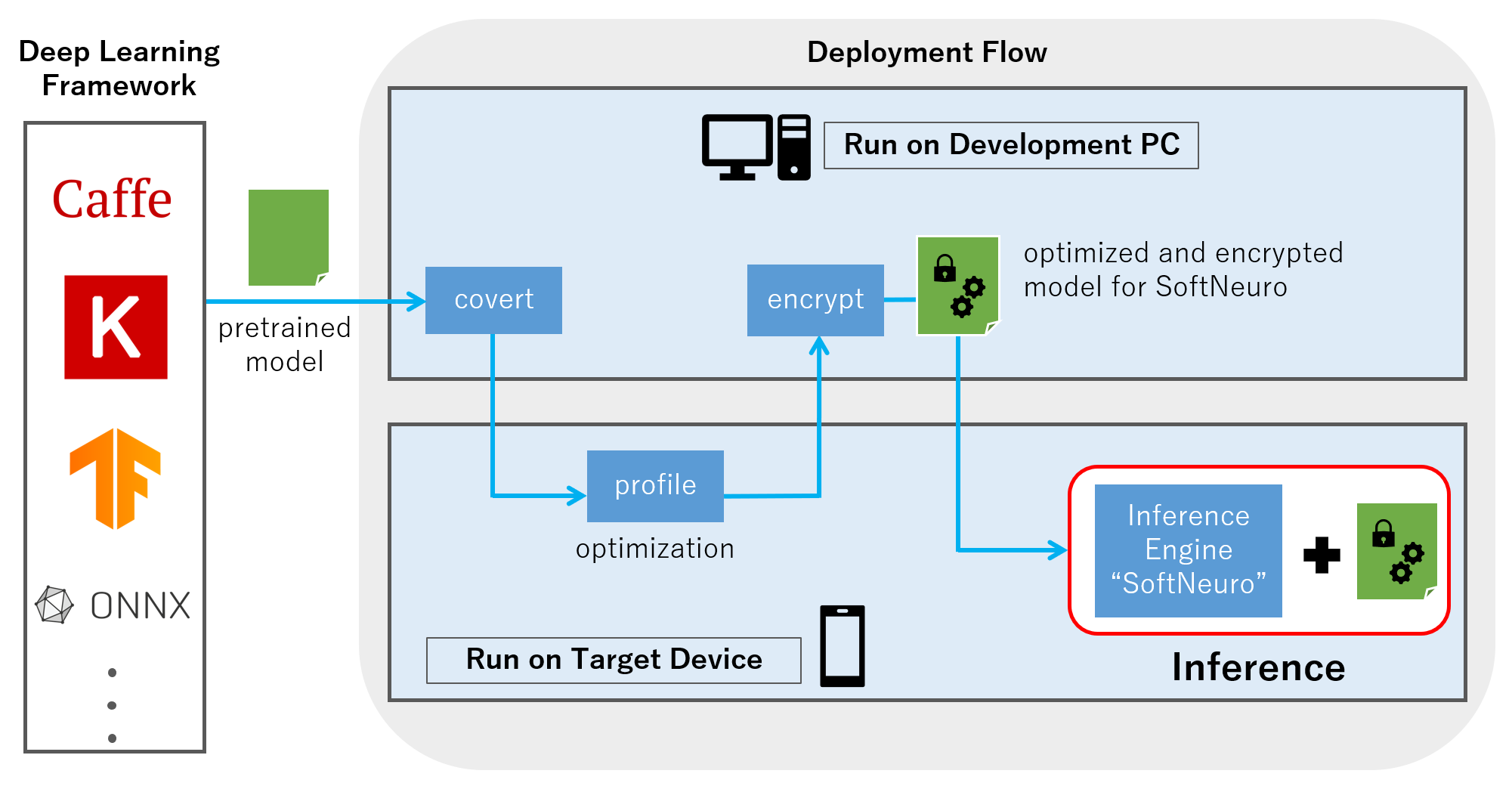

「SoftNeuro®」は、主要なディープラーニング・フレームワークの学習結果を活用して、高速な処理を実現します。(図2)各フレームワークのモデルファイルから、SoftNeuroで推論実行可能なファイル形式に変換するツール群を備えており、学習済みのモデル資産を無駄にすることなく、推論処理の高速化が可能です。

3.マルチプラットフォーム対応

「SoftNeuro®」は、現時点ではCPU、GPUでの推論が実行可能であり、順次多様なプラットフォームに応じた最適化(DSPの活用)も行う予定です。(図1)このマルチプラットフォーム対応により、学習結果を広範な動作プラットフォームへ展開することが容易になるだけでなく、動作プラットフォームの変更等に対する柔軟な対応可能となります。

4.セキュアファイルフォーマット対応

「SoftNeuro®」は、学習済みネットワークを暗号化する機能を有するため、学習時のノウハウや結果の漏洩リスクの軽減を実現します。

(※1)世界最速級:当社にて入手可能な主要な推論エンジンを比較対象としています。推論処理速度の測定は、当社にて入手可能な主要な推論エンジンを比較対象とし、CPU環境上で実施しています。(GPUは利用していません。)

推論処理速度測定結果は、図2の通りです。

・図1.「SoftNeuro」のシステム構成

・図2.推論処理速度測定結果(CPU:ARM)

測定環境:Snapdragon 855(推論対象画像サイズ 224×224ピクセル)

・AI製品相関図

Vision Product of the Year Awards 2018